Cuando se intenta "confundir" a los robots respecto a la posición en donde están ubicados, reaccionan como haría un ser humano, según los primeros resultados de un innovador proyecto europeo para mejorar la interacción de la robótica y las personas, liderado por un científico español.

Conseguir que los robots aprendan a reconocer su propio cuerpo y distinguirlo de otros elementos es el objetivo de este proyecto, llamado "SELFCEPTION".

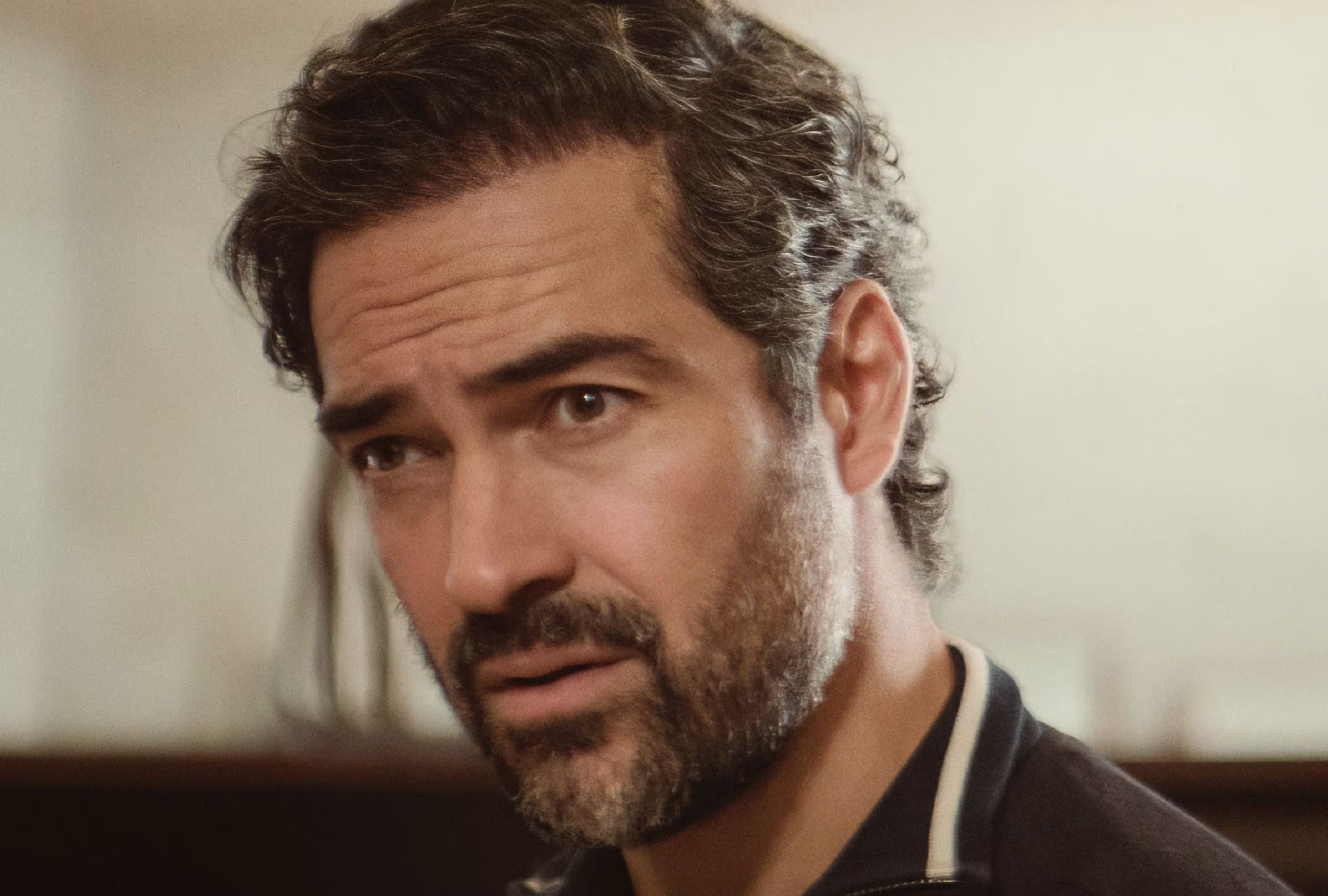

En el mismo trabaja el investigador Pablo Lanillos, experto en inteligencia artificial, junto con el director del Instituto de Sistemas Cognitivos Gordon Cheng de la Universidad Tecnológica de Múnich (TUM), en Alemania.

La investigación, en el marco de una prestigiosa beca europea Marie Sklodowsca-Curie, se encuentra aún en desarrollo y combina robótica con psicología cognitiva y cuyos resultados finales se validarán en colaboración con el fabricante español Pal Robotics.

Se sometió a robots con piel artificial a pruebas que los exponían a "ilusiones" para confundirlos mediante estimulación visual y táctil de forma conjunta.

El experimento les hacía creer que "su mano no era su mano", y el resultado confirmó por primera vez, en este ámbito de investigación, que "cuando se les crea ese tipo de ilusiones, los robots adaptan sus reacciones igual que los humanos".

Así los explicó Lanillos, doctor en inteligencia artificial por la Facultad de Informática de la Universidad Complutense de Madrid (UCM), con motivo de su participación esta semana en Madrid en el congreso mundial IROS 2018, donde fue finalista por el mejor artículo de robótica cognitiva.

Según el investigador español, los robots identifican sus posiciones de acuerdo con la información que reciben de sus sensores, como lo hacen las personas dependiendo de lo que ven, tocan o perciben con cualquier sentido.

El científico, inspirado por influyentes corrientes de la neurociencia actual, insistió en el gran avance que implicará para la interacción de las máquinas y las personas lograr que los robots lleguen a distinguir su propio "yo" del resto del mundo.

Actualmente, explicó, los robots domésticos apenas interactúan físicamente con las personas, y ni siquiera tienen extremidades en muchos casos.

No son más que bolas o cilindros a menudo, precisamente por seguridad, "dado que no son capaces de discernir el posible riesgo físico para al hombre que entrañan sus movimientos".

"Necesitamos robots flexibles, robots seguros, es decir, que sepan en todo momento dónde está su cuerpo y que sean conscientes de que si mueven un brazo generarán un efecto físico sobre el mundo a su alrededor", añadió Lanillos.

De hecho, sólo en Europa habrá más de 35 millones de robots privados para uso no industrial este mismo año, según las previsiones de los expertos.

"Cuando uno actúa y aprende de la interacción, el modelo incluye toda la incertidumbre del mundo"; si el modelo no ha estado nunca en la realidad "pasa por alto un montón de cosas" muy importantes, comentó el experto.

Por eso, prosiguió, para el aprendizaje de los robots, como con los humanos, también es "mejor actuar primero y aprender después".

Otro de los objetivos de esta investigación es intentar identificar claves desde la robótica sobre cómo los humanos construyen su propia representación física del mundo y son capaces de percibirse a sí mismos como individuos independientes.

De hecho, explicó, la causa de muchas enfermedades se debe a cómo ciertas personas integran las señales que reciben en el cuerpo. Por eso, otro de los retos es lograr que los avances en robótica puedan aplicarse también a nuevas terapias sanitarias.

Lanillos ha pasado por entidades de prestigio como el Instituto Tecnológico de Massachusetts (MIT) o el Laboratorio de Inteligencia Artificial de la Escuela Politécnica de Lausanne (Suiza), y es director de la delegación bávara de la Asociación de Científicos Españoles en Alemania (CERFA).

(Fuente: EFE)

:quality(75)/arc-anglerfish-arc2-prod-elcomercio.s3.amazonaws.com/public/YK6W4KDMBRBKRMP7AZ7HWZ3IZM.jpg)